WinSumption- Présentation des persona

Présentation et explication des personas

Cet article présente les différents personas impliqués dans l’utilisation de notre produit. A chaque persona est associé une explication en lien avec les recherches terrains que nous avons réalisées.

Article rédigé par : Anass BENFATHALLAH, Jean GUILLAUME, Emile LALO, et Eric TOBITT

Suite aux différentes données recueillies lors de la recherche terrain et l’état de l’art, des profils “types” d’utilisateurs ont pu être dégagés. Il est intéressant de réaliser ces personas dans l’optique d’identifier les fonctionnalités primordiales à l’utilisateur type.

Persona n°1: Le directeur de résidence, utilisateur de notre solution

Explications :

Les différents entretiens passés avec le directeur de la Maisel, nous ont permis d’établir le persona de Didier, quadragénaire et Directeur de résidence étudiante. Didier n’est pas décisionnaire dans l’implémentation de notre solution dans sa résidence, mais il reste le principal utilisateur. Il est donc important que l’utilisation de notre solution correspondent aux critères de Didier.

Didier travaille au contact d’étudiants et essaie d’être à jour sur les nouvelles technologies. Cela nous donne la possibilité de développer une IHM (Interface Homme-Machine) via une application, car Didier est familier de ce genre de technologie. Didier va être amené à utiliser notre application quotidiennement, il est donc nécessaire que notre interface soit ergonomique pour lui permettre d’accéder rapidement aux informations recherchées. Lors de notre premier entretien avec le responsable de notre résidence étudiante, nous avons remarqué que celui-ci était déjà assez informé sur les solutions connectées existantes et qu’il a même choisi des systèmes de régulation associés aux radiateurs des espaces communs de certains bâtiments.

Didier est actif et social. Il n’a pas volonté de punir les étudiants qui surconsomment mais simplement de les informer. Il sera donc intéressant de proposer une fonctionnalité d’envoi automatisé d’alertes aux étudiants qui consomment trop d’énergie.

Didier, comme beaucoup de directeurs(trices) de résidence a deux enfants : il souhaite laisser à ses enfants une planète en bon état. Ainsi il porte de plus en plus d’attention à sa consommation d’énergie, et limite son usage de la voiture.

De plus cela ne lui laisse qu’un temps limité à investir dans son travail. La solution devra donc être facile d’utilisation, avec une prise en main rapide.

Suite à notre deuxième entretien avec le directeur notre résidence étudiante, nous avons ressenti sa forte volonté de sensibiliser les résidents aux bonnes pratiques de l’économie d’énergie. Ne pouvant implémenter des solutions trop coûteuses, il cherche donc un moyen efficace pour sensibiliser les étudiants compatible avec son budget restreint. Ainsi, Didier travaille au fur et à mesure avec ses délégués résidents (ie des élèves responsables de la communication entre les résidents et la Maisel) afin de les rendre conscients des problèmes de surconsommation d’énergie.

Persona n°2 : Le résident de logement, qui est affecté par les changements amenés par notre solution

Explications:

Le questionnaire envoyé aux résidants nous a permis d’établir ce persona. Pour rappel, voici les points importants que nous avons pu identifier grâce à ce questionnaire :

- Une grande majorité des étudiants sont sensibles à l’écologie et pensent que des efforts en terme de consommation énergétique sont à faire à la Maisel

- Seule une minorité des étudiants sont prêt à payer plus pour réduire leur impact environnemental

- Une majorité n’est pas favorable à payer directement ce qu’ils consomment. On peut penser que les résidents non favorables pensent consommer en excès ce qui explique qu’ils préfèrent payer un forfait.

- La majorité des élèves estime à plus de 20 °C la température idéale du logement.

Grâce à ces éléments nous avons pu réaliser le persona d’Émile, 23 ans et résident en résidence étudiante. Émile représente les étudiants sceptiques à notre solution.

Émile n’est pas très impliqué dans l’écologie bien qu’il se sente concerné par les problèmes environnementaux (comme une majorité des étudiants selon le questionnaire que nous avons envoyé). Il n’est pas informé sur sa consommation et, par peur de trop consommer, préfère une facturation commune des charges. Cette facturation commune le pousse par moment, à consommer en excès sans se soucier de l’impact environnemental que cela peut avoir. Il va donc être important d’envisager une solution permettant de sensibiliser, d’informer et de motiver les résidents à faire attention à la surconsommation énergétique.

Les motivations et attentes d’Emile (travailler au calme, se coucher tranquillement, inviter ses amis de temps en temps) correspondent à celles de l’étudiant insouciant qui vit dans le présent, l’esprit occupé par ses nombreuses activités extrascolaires. Ce type d’étudiant ne met pas (en général) les enjeux environnementaux parmi ses priorités.

Dépendant encore de ses parents financièrement, Émile n’est pas prêt à payer pour réduire son impact environnemental. Il faut donc que la solution choisie n’implique pas des coûts trop importants pouvant être traduits par une augmentation des loyers.

Persona 3 : Le décisionnaire, un directeur de conseil d’administration d’école, qui décide d’implémenter notre solution

Lors d’un de nos entretiens, le directeur de la Maisel nous a informé que les projets de rénovation de la résidence étaient votés par un Conseil d’Administration. Le CA de l’IMT a récemment approuvé un projet de rénovation de certains bâtiments les rendants plus écologiques et un projet de construction de deux nouveaux bâtiments éco-responsables.

Christophe est pragmatique et a conscience qu’une gestion manquant d’éco-responsabilité peut nuire à l’image de son école. Son objectif est donc d’investir intelligemment dans des solutions lui permettant d’améliorer la responsabilité sociétale de l’école.

Christophe, en tant que décisionnaire, est donc prêt à investir sur des solutions écologiques, dans l’optique d’augmenter l’attractivité de la résidence étudiante.

Il est très impliqué dans son travail et ne néglige aucune suggestion d’amélioration ou de progrès.

Ayant fait des études poussées, et étant régulièrement confrontés aux enjeux de transition digitale, il est ouvert aux solutions technologiques.

En tant qu’homme d’affaire et Directeur Financier, la valorisation de l’implémentation de la solution doit être rapide. Il sera donc favorable à des solutions peu coûteuses et ayant un fort impact.

Persona 4 : Le résident très sensibilisé, et acteur du Développement Durable, qui accueillera favorablement notre solution dans son logement

Philippe représente les étudiants très favorables à notre solution.

Philippe est sensible à l’environnement et acteur du Développement Durable. Il a conscience des enjeux écologiques importants, et il est prêt à sacrifier un peu de confort pour réduire son impact environnemental.

Philippe est également actif dans une association environnementale. Il souhaite sensibiliser un maximum de personnes aux efforts environnementaux nécessaires. Notre solution permet aux résidents de recevoir des retours sur leurs consommations d’énergie. Philippe compte bien profiter de cela pour alimenter sa campagne de sensibilisation.

Philippe étant social, il sera amené à vanter les bienfaits de notre solution aux autres résidents permettant un accueil favorable de la part des étudiants plus réticents.

SmartSéc – Expression de besoin

Dans cet article, nous exprimerons le besoin de nos utilisateurs à travers la présentation des backlogs et des user’s stories. Cependant, avant, nous ferons un bref rappel du contexte et de la problématique sur lesquels repose notre projet, ainsi que de la solution que nous proposons.

Contexte et problème

Selon l’ONU, l’agriculture familiale est responsable d’environ 70% de la production agricole mondiale. De plus, les statistiques montrent que l’activité est l’un de principaux piliers économiques dans les pays en développement, une fois qu’elle assure la subsistance de 2,5 milliards de personnes (FAO, 2003 ; XIE, AWOKUSE, 2014).

Les agriculteurs familiaux, malgré leur importance pour l’approvisionnement alimentaire mondiale, sont constamment menacés par le manque de ressources technologiques, de connaissances techniques et d’infrastructure de base. D’abord, l’analphabétisme touchant environ 50% de la population rurale, allié au manque de connaissances techniques, fait que leur productivité soit 3 fois plus faible que celle de grands agriculteurs (ALOJEDE, 2013).

En outre, on voit, par exemple, que l’électricité n’était présent qu’en 38% d’établissements d’agriculture familiale en 2010. Cela signifie donc que la mise en place de certains types de technologies était, et l’est toujours, irréalisable (MEIRELLES, FILHO, 2015).

Compte tenu de ce contexte et de cette problématique, nous nous demandions “Comment pouvons-nous aider les agriculteurs familiaux à augmenter leurs profits ?”

On a trouvé que, la conservation des aliments présentant un vrai défi pour les agriculteurs familiaux, le séchage solaire traditionnel est la méthode la plus utilisée, surtout dans les pays en développement. Cependant, le problème qui se pose est que les techniques utilisées restent rudimentaires et aboutissent généralement à des productions de qualité médiocre, à cause de la mauvaise gestion du processus de séchage (ÇENGEL, 2012).

Solution

Ainsi, nous proposons un séchoir solaire photovoltaïque équipé par des systèmes de ventilation et de contrôle de température et d’humidité.

Les systèmes de contrôle sont composés par des capteurs et des ventilateurs, liés à une carte électronique qui enverra les données à une application mobile. Cette application va recevoir et afficher les mesures de température et d’humidité en temps réel ainsi que permettre au utilisateur d’accéder à des informations pertinentes (telles que les limites de température et d’humidité) sur divers produits. Une autre fonctionnalité de notre application est l’envoi de notifications pour avertir l’utilisateur si la température à l’intérieur du séchoir dépasse celle qui est recommandée pour le produit.

Étant donné que l’accès à l’électricité peut présenter un problème dans certaines zones, on utilise des panneaux solaires pour alimenter la carte et les ventilateurs.

Selon les données recueillies lors de l’étude de terrain, la plupart de nos utilisateurs ont peu de connaissances techniques et sont peu familiarisés avec l’utilisation des smartphones. Ainsi, dans un premier temps, nous visons à développer une application simple et facile à utiliser ; cependant, au fur et à mesure que le processus de prototypage agile avance, nous apporterons les modifications nécessaires afin que notre produit réponde aux besoins des utilisateurs.

Backlog

Dans un premier temps, nous présentons la première version de notre backlog, Figure 1 (cliquez pour visualiser) réalisé le 6 novembre.

On y trouve les trois principales users’ stories de notre projet :

-

Suivi en temps réel des valeurs de température et d’humidité: il permet à l’utilisateur de visualiser automatiquement les variables du processus de séchage. Les données sont transmises de la carte électronique à l’application via un système sans fil (pour le prototype qui sera présenté à la fin du semestre, nous utiliserons Bluetooth ; pour les autres cas, une étude sur les canaux de communication sans fil les plus appropriés est nécessaire).

-

Contrôle des ventilateurs: si la température dépasse la limite recommandée par l’application, l’utilisateur pourra mettre en marche les ventilateurs afin de disperser la chaleur et procéder au séchage.

-

Accès à des recommandations de séchage: comme nos utilisateurs ont peu de connaissances techniques, notre application leur permet d’accéder à une base de données contenant des informations sur la plage optimale de température et d’humidité pour le traitement des produits.

Pour la dernière version de notre backlog, Figure 2 (cliquez pour visualiser), nous avons ajouté trois autres user’s stories :

-

Notification de température: si la température dépasse la limite, l’utilisateur doit être averti par une notification push, afin de faciliter la gestion du processus de séchage et d’éviter d’endommager la structure physico-chimique du matériau final.

-

Notification d’humidité: si l’humidité de l’aliment atteint la valeur préréglée par l’application, l’utilisateur doit recevoir une notification push, afin qu’il puisse stopper le processus de séchage.

-

Obtention du matériel (capteurs, modules de transmission sans fil, entre autres): dans ce cas, il s’agit d’une » histoire de développeur « , car c’est une des conditions Les matériaux nécessaires doivent être répertoriés et nous nous rendrons ensuite au FabLab pour vérifier leur disponibilité.

Nous avons fait cette dernière version du backlog parce que nous avons réalisé l’importance d’ajouter des notifications pour alerter l’utilisateur au cas où l’une des variables du processus atteindrait des valeurs critiques. En effet, un séchage prolongé dans de telles situations pourrait endommager le produit et entraîner une perte de qualité et de rendement.

Auteurs:

SANTANA Rodrigo

YIN Tan

FERJANI Wadia

References

Food and Agriculture Organization of the United Nations, « Statistics », Food and Agriculture Organization of the United Nations. [En ligne]. Disponible sur: http://www.fao.org/statistics/en/. [Consulté le: 14-oct-2019].

O. Awokuse et R. Xie, « Does Agriculture Really Matter for Economic Growth in Developing Countries? », Canadian Journal of Agricultural Economics/Revue canadienne d’agroeconomie, vol. 63, no 1, p. 77‑99, 2015.

M. de S. Filho, A. M. Buainain, C. Guanziroli, et Batalha, « Agricultura familiar – Vol. II », Issuu. [En ligne]. Disponible sur: https://issuu.com/editoraunicamp/docs/528. [Consulté le: 27-oct-2019].

Olojede, « Analysis of rural literacy as a panacea for socio-economy development of Nigeria », Int. J. Sociol. Anthropol., vol. 5, no 9, p. 381‑390, déc. 2013.

ÇENGEL, Yunus A.; GHAJAR, Afshin J. Transferência de calor e massa: Uma Abordagem Prática. 4. ed. Porto Alegre: AMGH EDITORA LTDA, 2012. 904 p.

SmartSéc – Maquettage

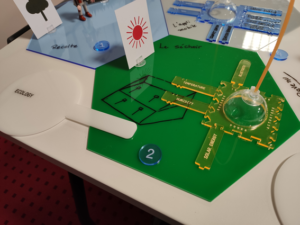

Le maquettage présenté à la Figure 1 vise à illustrer, de façon générale, la problématique et la solution proposée grâce à l’utilisation de notre produit, le séchoir solaire intelligent SmartSéc.

Figure 1 – Maquettage finalisé

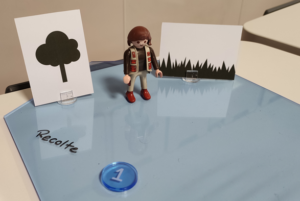

La première partie, Figure 2, représente les agriculteurs familiaux après la récolte. Les produits récoltés sont ensuite introduits dans le séchoir (Figure 3), qui dispose de capteurs de température et d’humidité ; ces capteurs transmettent ces données, par bluetooth, à l’application mobile (Figure 4). Grâce à l’application, les agriculteurs ont accès à l’information sur le séchage afin d’optimiser le processus et d’augmenter leur productivité ; en outre, il est possible de visualiser en temps réel les valeurs d’humidité et de température à l’intérieur du sécheur, ainsi que de le désactiver à distance.

Figure 2 – Les agriculteurs familiaux

Figure 4 – L’application mobile

La dernière partie, la Figure 5, montre les impacts que l’utilisation de notre produit apportera à la société, les principaux étant l’augmentation des revenus des agriculteurs familiaux (due à la réduction des pertes pendant le processus de séchage), suivie d’une amélioration de leur qualité de vie et de leur intégration sociale (due au fait d’intégrer au monde technologique une population rurale souvent négligée par l’Etat).

Figure 5 – La societé

Auteurs:

SANTANA Rodrigo

YIN Tan

FERJANI Wadia

MindPeace – État de l’art

Auteurs: GHANDI Sanaa- LAFEUILLADE Timothée- Ilona Mallein-Gerin

Plan:

- Introduction

- Définitions

- Problématique

- Solutions existantes

- Conclusion

- Sources

I–Introduction

L’apprentissage des enfants en situation de handicap est un sujet crucial pour notre société, qui devrait être capable d’aider ces enfants au nom de l’égalité, et de protéger les plus faibles, en leur permettant d’avoir facilement accès au savoir. Ce sujet était particulièrement important et intéressant pour nous, car il met en jeu la construction des générations futures. Le handicap de ces enfants est un problème pour eux, mais aussi pour les parents et les professeurs et ceci fait appel à des notions psychologiques, sociales et éducatives que nous trouvions intéressantes. Nous étions donc particulièrement intéressés par cette problématique vu que nous savions de près quelques familles se trouvant dans ces situations. Par ailleurs le fait que quelques membres du groupe sont passionnés par la psychologie et les sciences cognitives nous a encouragé davantage à découvrir ce sujet et à essayer de faire de notre mieux en vue de pouvoir améliorer le quotidien de ces enfants ainsi que de leurs familles.

Nous allons pour ce faire dans un premiers temps définir le sujet et les éléments qui entrent en jeu, avant de cerner notre problématique et présenter les solutions existantes. Finalement nous allons énoncer nos hypothèses de travail et nos orientations de conception suite à ce travail de recherche.

II–Définitions

1.L’attention et ses troubles

a-Les troubles d’attention

Les troubles d’attention sont définis comme des troubles neurodéveloppementaux qui répondent à un diagnostic médical et se caractérisent par l’expression de symptômes d’inattention, d’impulsivité et d’hyperactivité. Ils sont spécifiques à chaque enfant et peuvent varier dans leur intensité en fonction de son profil et de son environnement . [23]

Ces troubles touchent environ 5% des enfants d’âge scolaire et leurs origines sont diverses: facteurs génétiques, héréditaires et environnementaux précoces[1]. Généralement diagnostiqués à l’étape de l’enfance, ces troubles continuent très souvent à se manifester à l’âge adulte.[24]

Le diagnostic s’effectue à l’aide d’un bilan neuropsychologique appelé TEA-Ch(Test d’évaluation d’Attention chez l’enfant) qui comporte plusieurs exercices chacun mesurant une forme d’attention particulière ou une combinaison de ces formes. [3]

Mais afin de bien comprendre ce qu’est un trouble d’attention il convient alors de définir l’attention ou plutôt les attentions.

b-Qu’est ce que l’attention ?

Selon le dictionnaire Larousse l’attention peut être défini comme la capacité de concentrer volontairement son esprit sur un objet déterminé.[26] Et en psychologie l’attention est la mobilisation de la vigilance du sujet, se fixant sur un objet précis et reléguant à l’arrière-plan les autres éléments composant le champ psychologique [25]

Selon une étude menée par Cooley et Morris en 1990, l’attention contient trois composantes principales qui sont [2]:

- L’attention sélective visuelle et auditive: la capacité de sélectionner, dans l’environnement, les informations cibles et d’ignorer les stimulations non pertinentes ou distractives

- L’attention soutenue: la capacité de maintenir un niveau d’attention suffisant pendant une longue période de temps

- L’attention divisée: la capacité de répartir son attention entre plusieurs tâches ou sources d’information. [3]

Ces troubles d’attention sont en particuliers présents chez les enfants autistes et trisomiques mais se manifestent souvent de façon différente selon chaque enfant et chaque spécificité. Nous allons donc essayer de comprendre les fonctionnements et les difficultés des enfants autistes et trisomiques afin de mieux s’approcher de leurs besoins ainsi que de cerner notre champ d’action et de recherche.

2.Les enfants autistes

a-C’est quoi l’autisme?

L’autisme et les troubles envahissants du développement (TED) sont des troubles neurodéveloppementaux qui débutent durant les premières années de vie, caractérisés d’un point de vue clinique par :

- Des altérations qualitatives des interactions sociales

- Des altérations qualitatives de la communication

- Un répertoire d’intérêts et d’activités restreint, stéréotypé et répétitif

Les études épidémiologiques récentes indiquent que les TED touchent environ 0.6% des personnes. [1]

b-Un autisme ou Des autismes?

Nous avions choisi de visionner des vidéos et reportages pour s’approcher le plus possible du quotidien des parents et comprendre leurs difficultés ainsi que les spécificités de leurs enfants.[5] , [6] , [7]

Ceci nous a permis de comprendre qu’Il y’a autant d’autismes que d’enfants autistes, et qu’en effet malgré des traits de caractère et de comportement communs, l’éducation de chaque enfant autiste nécessite des aménagements spécifiques de la part des parents et du centre de l’éducation de l’enfant. Ceci dit, on pourrait tout de même classer l’autisme dans trois catégories majeures comme suit :

- L’autisme modéré ou haut niveau: Dans ce cas là, l’enfant a un minimum d’interactions sociales avec son entourage. Il peut aussi participer à plusieurs activités et rester seul à la maison ce qui relève d’une certaine autonomie qui requiert généralement beaucoup de temps et un apprentissage spécifique avant d’être acquise. En revanche, la plupart des enfants dans ce cas là ont besoin tout de même d’être accompagnés dans leurs activités quotidienne en dehors de la maison et ceci est dû au fait qu’il rencontrent un problème de repérage dans l’espace ainsi qu’ils sont facilement agressés par les lumières( supermarchés, phares de voitures, panneaux publicitaires) et les bruits vu qu’ils ont souvent des sens plus développés.

- L’autisme Asperger: Les Aspergers se distinguent par leur douance dans un domaine particulier dès leur plus jeune âge et ils peuvent faire preuves de certaines formes d’interaction sociale.

- L’autisme sévère: l’interaction sociale devient presque inexistante et rend ainsi l’éducation de l’enfant très difficile voire impossible dans certains cas.

c-L’autisme et les troubles d’attention?

Vu que les autistes ont des sens surdéveloppés et ne disposent pas de la capacité à hiérarchiser les informations qu’ils reçoivent ils se trouvent souvent éparpillés devant toutes les distractions qu’ils rencontrent et perdent ainsi de vue leur objectif initial.

Par ailleurs les enfants autistes sont souvent victimes de crises de panique face à des situations imprévisibles ce qui inhibent leur prise d’initiative et les rendent incapables à focaliser leur attention sur une tâche particulière.

3.Les enfants trisomiques

a-La trisomie

Chez un individu normal, qui ne souffre pas de trisomie, les chromosomes vont par paires. On compte 23 paires de chromosomes chez l’Homme, soit 46 chromosomes en tout. On parle de trisomie lorsqu’une des paires au moins ne possède pas deux, mais trois chromosomes. Cette anomalie chromosomique peut survenir lors de la répartition du patrimoine génétique des deux partenaires lors de la création des gamètes (ovocyte et spermatozoïde), puis lors de la fécondation. La trisomie peut concerner n’importe quelle paire de chromosome, la plus connue étant celle qui concerne la 21e paire de chromosomes. [28]

b-Les enfants trisomiques et les émotions

Une personne qui présente le syndrome de Down ou la trisomie 21 manifeste de façon très explicite ses émotions (bonheur,tristesse, gratitude, hostilité, tendresse, etc.) et toute la gamme des comportements affectifs.[29]

c-Les enfants trisomiques et l’éducation

Puisque le développement des enfants trisomiques est plus lent, le fossé entre les autres enfants de leur âge et eux se creuse avec les années. Des spécialistes recommandent toutefois de les inscrire dans des établissements d’enseignement secondaire ordinaires, pourvu que les parents et les professeurs soient d’accord et qu’il y ait une possibilité d’assistance aux élèves en difficulté. [9]

Cependant, les enfants porteurs de trisomie 21 ont parfois du mal à apprendre aussi vite que les autres avec les méthodes traditionnelles, car pour les spécialistes de la psychologie du développement la caractéristique centrale de la trisomie 21 est l’effet qu’elle a sur la capacité d’apprentissage des personnes atteintes. [10]

d- Les enfants trisomiques et l’attention

Contrairement aux enfants autistes qui se perdent dans toutes les stimulations qu’ils peuvent percevoir, les trisomiques sont plutôt inhibés face à ce qui les entoure et ont besoin donc d’être stimulés périodiquement afin de les maintenir attentifs.

III–Problématiques soulevées

Notre problématique principale était de pouvoir améliorer l’apprentissage des enfants autistes et trisomiques mais nous nous sommes rendus compte que ceci regorge plusieurs sous problématiques. Ceci est dû d’une part à l’hétérogénéité des profils autant dans le spectre autistique que dans la trisomie et d’une autre part de la diversités des attentions et des troubles qui y sont liés et finalement du fait que ces deux aspects vont très souvent de pair .

Nous avons donc établit les problématiques suivantes:

- Comment rassurer un enfant autiste?

- Comment capter son attention?

- Comment l’aider en cas d’imprévu?

- Comment rassurer un enfant trisomique et comment réussir à le stimuler?

- Comment rendre notre objet communicant le plus personnalisable possible?

- Comment adapter cet outil pour qu’il puisse servir aux deux catégories d’enfants voire un panel plus large pour tous les enfants souffrant de tda?

IV–Solutions existantes

1)Solutions humaines

a-Méthodes spécifiques mise en place par l’éducation nationale

Dans un but d’inclusion des personnes souffrant d’un handicap dans le système scolaire français, l’Education nationale a mis en place plusieurs dispositifs.

Ainsi, le dispositif ULIS (Unité Localisée pour l’Inclusion Scolaire) existe dans de nombreux établissements. Il est réservé aux élèves ayant des troubles, que ce soit au niveau des fonctions cognitives ou mentales, au niveau de la motricité ou autre, et qui ont des difficultés à suivre et à s’intégrer dans une classe traditionnelle. Les élèves sont encadrés par une équipe éducative adaptée et reçoivent un enseignement personnalisé.[11]

L’éducation nationale offre aussi la possibilité d’avoir un Auxiliaire de Vie Scolaire (AVS). Cette personne apporte une aide pour optimiser l’autonomie de l’enfant dans les apprentissages, de faciliter sa participation aux activités collectives et aux relations interindividuelles et d’assurer son installation dans des conditions optimales de sécurité et de confort.

Toutefois, ces solutions sont souvent pénibles administrativement pour les parents car pour y avoir accès il faut connaître et réaliser les démarches nécessaires. [12]

Toutes les écoles ne peuvent pas forcément se doter de tels dispositifs, c’est pourquoi l’Éducation nationale met à disposition des enseignants de nombreux conseils et guides pour la scolarisation des élèves en situation de handicap. Elle préconise ainsi certains comportements à adopter pour les professeurs ayant de tels élèves. Ils sont ainsi incités à se renseigner auprès des parents des habitudes de l’enfant, une vraie coopération doit s’installer entre les parents et l’enseignant. Cela permet une personnalisation de l’aide apportée. L’enseignant doit ensuite s’assurer d’inclure l’élève dans la vie de la classe tant au niveau scolaire (en répétant, reformulant les consignes ou les bilans) qu’au niveau social (en explicitant les règles de vie, les codes sociaux). L’enseignant doit adapter sa manière de communiquer. Il est aussi conseillé de valoriser régulièrement les accomplissements de l’enfant, pour lui donner confiance en lui. Enfin, l’enseignant peut donner un temps d’appropriation individuelle à l’enfant en cas d’activité ou de jeux.

Nous avons identifié dans ces recommandations certains aspects qui nous ont paru important pour l’optimisation de l’apprentissage d’un enfant atteint de troubles cognitifs. Ces caractéristiques devraient transparaître d’une certaine manière dans notre solution technique. Il s’agit de permettre un accompagnement personnalisable à chaque enfant, leur apporter un sentiment de sécurité et de confiance en soi, le tout effectué d’une manière adaptée à leurs méthodes de compréhension. [13]

Malgré les dispositifs mis en place par l’éducation nationale, suivre un parcours dans une école classique reste très difficile pour ces enfants. C’est pourquoi il existe plusieurs méthodes et approches qui offrent des solutions d’apprentissages autre que l’école.

Il y a par exemple la méthode TEACCH (Treatment and education of autistic and related communication handicapped children). Cette méthode vise à développer l’autonomie d’une personne autiste. Le principe est de réunir une équipe éducative composée d’experts, de psychologues mais aussi des parents travaillant en étroite collaboration. Cette méthode consiste à créer un environnement autour de l’enfant et à le structurer et l’adapter progressivement. Elle apprend à l’enfant à réaliser des tâches de la vie quotidienne par la répétition. Des supports visuels sont utilisés pour rendre les activités et leur ordre de déroulement compréhensibles.[14]

Selon le docteur en psychologie Vinca Rivière, la méthode TEACCH est très efficace au cours des trois premières années. Toutefois, après ce laps de temps, le développement à tendance à stagner. De plus, cette méthode, qui met l’accent sur le gain d’autonomie, ne permet pas le développement du langage et à tendance à isoler plus qu’à intégrer l’enfant.[15]

Il existe aussi la méthode PECS (Picture Exchange Communication System). Cette approche, développée d’abord spécialement pour les autistes, concerne des personnes ayant différents types de troubles, cognitifs, physiques et de communication. Il s’agit d’un protocole d’enseignement permettant la communication fonctionnelle, à savoir la communication à partir d’images. Il est composé de six phases. L’enfant apprend d’abord comment communiquer, en échangeant une image contre un objet ou une activité. Ensuite il apprend à choisir entre plusieurs images. Enfin, il apprend progressivement à former des phrases simples à l’aide de suites d’images, et à répondre à des questions.

L’avantage de cette méthode est qu’elle ne nécessite pas une équipe de spécialistes. Elle peut être mise en pratique par les parents une fois que ceux-ci s’y sont formés.[16] [17]

Ces méthodes d’apprentissage sont globalement efficaces, mais coûteuses en moyens humains et matériels. Appliquer les principes de ces méthodes à des solutions techniques permettrait d’éviter l’abondance de spécialistes sollicités ainsi que le grand nombre de supports parfois nécessaires. Nous comptons ainsi reprendre certains de ces concepts pour les adapter à notre objet communicant.

b-Dans le cas d’un centre classique sans aménagements particuliers, parents ou enseignants les bons gestes à adopter face à un enfant souffrant de TDA:

Dans le cas de centres ne disposant pas d’aménagement particulier ou pour le cas des enfants scolarisés à la maison des gestes simples adoptés par l’enseignant ou le parent peuvent attribuer grandement à l’amélioration de l’attention de cet enfant on pourrait citer par exemple [8] :

-Privilégier les matins

-Permettre à l’enfant de faire des pauses

-Canaliser son énergie excessive en lui donnant des tâches à faire

-Encourager l’enfant continuellement afin d’améliorer son estime de soi et l’accompagner dans ses comportement d’évitement et de procrastination en lui demandant à chaque fois des progrès simples à effectuer

-Enlever toutes les distractions( photos, schémas etc) et le mettre près d’enfants sérieux en classe

-Avoir des instructions claires et aider l’enfant dans son organisation voire implémenter des routines d’apprentissage

-Matérialiser le temps qui passe par un sablier par exemple

-Impliquer l’enfant de manière active et prévenir des changement quelques minutes avant car ces enfants ne disposent pas d’une grande flexibilité cognitive

-Donner un temps supplémentaire dans les tâches

-Ne pas donner de doubles tâches

-Scinder les consignes et les exercices dans un examen

c-Rééducation de l’attention et de l’inhibition

La rééducation de l’attention sélective visuelle comporte des repérages de cibles visuelles dans le cadre de jeux de barrages (par exemple, barrer les « e » dans un texte), des recherches de cibles dans des environnements visuels très complexes (livres « où est charly ? », par exemple) et des repérages de différences entre deux dessins.

La rééducation de l’attention sélective auditive comporte des repérages de cibles auditives (un mot dans un texte lu, un son dans une liste de mots entendus, etc.).

La rééducation de l’attention divisée consiste à proposer à l’enfant des jeux dans lesquels il doit à la fois repérer, simultanément, des cibles visuelles et des cibles auditives.

Et enfin, la rééducation de l’inhibition utilise des exercices dans lesquels l’enfant doit inhiber des automatismes verbaux ou moteurs. Dans le premier cas, il s’agit, par exemple, de jeux comme le « ni oui ni non » (dans lequel l’enfant doit répondre à des questions sans utiliser les mots « oui » et « non ») ou d’exercices où l’enfant doit lire le plus vite possible une séquence de « o » et de « a » qui sont, le plus souvent, mais pas toujours, disposés en alternance (aoaoaoaoaooaoaoaoaao…). Dans le second, il s’agit de jeux comme celui du « Jacques a dit » (le meneur de jeu donne des ordres au joueur, celui-ci doit obtempérer le plus vite possible mais seulement si ces demandes sont précédées de « Jacques a dit ») ou encore d’exercices où il faut barrer, très vite, toutes les lettres d’un texte sauf le « o ».[3]

Cette approche menée à l’Université catholique de Louvain [3] a démontré une nette amélioration des différentes formes d’attention ainsi que d’inhibition suite à cette rééducation qui consistait en des séances hebdomadaires de 45 min pendant 20 semaines.

2)Solutions techniques

Les nouvelles technologies permettent un nouveau regard sur les moyens d’optimiser l’éducation d’un enfant en situation de handicap. Plusieurs solutions techniques reprenant les principes des méthodes d’apprentissage traditionnelles existent déjà.

a-L’application PictoTask

C’est un dispositif pour les personnes présentant des troubles cognitifs. Ce dispositif met en relation une application et une montre connectée, et est paramétrable via tout appareil possédant une connexion internet. On peut ainsi y enregistrer un planning, une liste de tâches, des photos, des enregistrements vocaux, et bien d’autres. Cela permet principalement à l’utilisateur d’apprendre une routine et d’accéder à une certaine autonomie. Cela sert aussi d’alerte en cas de problème, ou de dispositif de géolocalisation si l’utilisateur se perd.

Cette application possède plusieurs avantages : elle est très complète avec beaucoup de paramétrages possibles, permettant une vraie personnalisation de l’application à chaque personne. Elle est aussi relativement ergonomique et facile d’utilisation.

Toutefois, elle présente aussi quelques défauts : son coût, ainsi que le temps, parfois journalier, qui est demandé au responsable pour paramétrer l’application. [18] [19]

L’objet que nous devrons concevoir pour notre projet sera plus simple et présentera moins de paramétrages possibles afin de ne pas retomber dans les mêmes points négatifs que PictoTask.

b-Les applications de CAA:

Concernant les problèmes de communication que peuvent rencontrer les enfants autistes et trisomiques, il existe plusieurs applications mettent en œuvre le CAA (Communication Améliorée Alternative). Il s’agit d’un ensemble de systèmes, d’outils et de stratégies pour aider à la communication pour les personnes ayant des difficultés au langage ou à l’interaction sociale. Le CAA peut être non assisté, c’est-à-dire qu’il ne nécessite pas d’outils physiques (par ex langage des signes) ou au contraire assisté à l’aide d’outils ou de matériel. [20]

-Proloquo2Go : Une application conçue pour les personnes qui ne peuvent pas faire usage de la parole, telles que les personnes atteintes d’autisme, du syndrome de Down, de paralysie cérébrale… Sur cette application, chaque mot est représenté par un symbole ou un pictogramme. Lorsque l’utilisateur sélectionne un mot, une voix pré-enregistrée le prononce. Cette application est adaptée à tout niveau d’utilisateurs ayant des problèmes de communication plus ou moins grand, et permet un apprentissage progressif allant de mots de vocabulaire limité à des phrases complètes avec du vocabulaire recherché.

-Proloquo4Text :Une application développée par la même société, visant le même public. C’est une application de synthèse vocale. L’utilisateur tape le texte qu’il veut exprimer puis active une voix de synthèse. L’application lui propose en anticipation des propositions de suite de phrase, pour permettre de gagner du temps dans cette communication qui peut parfois être lente et fastidieuse. Ces propositions sont créées à partir des habitudes de langage de l’utilisateur. [21]

CommunicoTool: Cette application se sert d’échange d’images comme mode de communication et permet aux enfants ayant des troubles du langage de s’exprimer plus facilement. Elle possède par exemple un mode permettant d’évaluer la douleur, un mode pour exprimer son humeur ou son ressenti et un mode permet de faire des phrases courtes avec des pictogrammes représentant chaque mot. Il y a aussi un planning qui permet de planifier le quotidien de l’enfant en séquençant les tâches à effectuer et avec la possibilité de programmer un timer pour allouer un temps à ces tâches.

Ce qui est intéressant avec cette application est son adaptabilité à l’utilisateur, et la facilité de programmation par celui-ci ou par ses proches. [22]

c-L’application Watchelp:

Wacthelp est une application qui aident les enfants à gagner en autonomie et à se repérer dans le temps développée par une mère d’un enfants autiste. Elle permet d’afficher les étapes des tâches quotidiennes à effectuer sur une montre connectée et demande aux enfants de répondre si la tâche a été accompli ou pas ce qui tient les parents au courant des activités de leurs enfants. Cette application convient aussi aux personnes déficients mentalement ou souffrant d’Alzheimer.[31]

d-L’applications Tsara:

L’application est à destination des personnes côtoyant un enfant autiste (parents, enseignants, aidants …) qui permet lors du jeu d’accompagner un jeune autiste et interagir avec lui dans diverses situations, ainsi selon les réactions que le joueur a choisi il obtient des recommandations et consignes à suivre dans de telles situations validées par des experts lui permettant d’améliorer ses attitudes face à des enfants autistes dans la vie réelle.[30]

V–Conclusion

Suite à nos recherche nous avons bien compris que chaque enfant est unique vis à vis de sa perception du monde et dans ses réactions aux différents stimulus extérieurs sauf que cette particularité est d’autant plus grande quand ces enfants ont un mode de fonctionnement différent du nôtre. Ceci dit, il revient à nous d’essayer de s’adapter à leurs besoins afin qu’ils puissent s’épanouir.

En effet, pour les enfants autistes, une structuration spatio-temporelle de leurs diverses activités ainsi qu’une source de stimulus légère leur permet de réduire leur anxiété et de canaliser leur attention afin d’être plus présent. Pour les enfants trisomiques, ils faut plus cibler leur côté affectif vivant et essayer de les stimuler en vue de les ressortir de leur inhibition.

Ainsi notre objet connecté devra être très personnalisable afin qu’on puisse garantir une large utilisation de ce dernier et de permettre à chaque parent de s’adapter aux besoins de son enfant.

Ainsi lors de nos recherches terrain nous aurions comme objectifs de clarifier les points suivants:

- La difficultés de concentration chez ces enfants

- La fréquence des crises de panique

- Les solutions que les parents ont déjà essayé

- Les difficultés rencontrés au quotidien

VI–Sources

[1]:Trouble déficit de l’attention/hyperactivité (TDAH): quels liens avec l’attachement? N. Franca,∗, M. Maurya, D. Purper-Ouakil https://patrickrouge.fr/wp-content/uploads/2018/08/Trouble_deficit_de_lattentionhyperactivite_TDAH_q.pdf ,consulté le 15/10/2019

[2] : Attention in children: A neuropsychologically based model for assessment

Eileen L. Cooley & Robin D. Morris

https://www.tandfonline.com/doi/abs/10.1080/87565649009540465, consulté le 03/11/2019

[3]:Rééducation neuropsychologique des troubles de l’attention et de l’inhibition chez l’enfant ,M.-P. NOËL, L. BASTIN , J. SCHNEIDER et D. POTTELLE https://dial.uclouvain.be/pr/boreal/object/boreal%3A76379/datastream/PDF_01/view, consulté le 15/10/2019

[4]:Modèles neuropsychologiques dans l’autisme et les troubles envahissants du développement, Giovanni Valeri et Mario Speranza https://www.cairn.info/revue-developpements-2009-1-page-34.htm, consulté le 15/10/2019

[5]:Autisme : il dévoile son univers ! – Ça se discute

https://www.youtube.com/watch?v=lsjanZ9ky4c, consulté le 15/10/2019

[6]: Comment éduquer un enfant autiste ? – Ça se discute

https://www.youtube.com/watch?v=JjkJV9a2c3o, consulté le 15/10/2019

[7]:Autisme : le quotidien d’une mère – Ça se discute

https://www.youtube.com/watch?v=YI8kmTzVQ0A, consulté le 15/10/2019

[8]: Remédiation cognitive des troubles attentionnels : des aspects théoriques aux applications cliniques, Anne-Marie TONINATO

https://www.tdah-france.fr/Remediation-cognitive-des-troubles.html?lang=fr ,consulté le 15/10/2019

[9]: L’éducation d’un enfant trisomique : Les difficultés, les joies, Inconnu

https://wol.jw.org/fr/wol/d/r30/lp-f/102011207#h=37, consulté le 15/10/2019

[10]:Le développement cognitif chez les jeunes enfants atteints de trisomie 21 : forces et faiblesses, Jennifer G. Wishart. Burnaby, BC : Down Syndrome Resource Foundation

https://www.dsrf.org/information/other-languages/le-d%C3%A9veloppement-cognitif-chez-les-jeunes-enfants-atteints-de-trisomie-21—forces-et-faiblesses, consulté le 15/10/2019

[11]:Les unités localisées pour l’inclusion scolaire (ULIS), des dispositifs pour la scolarisation des élèves en situation de handicap dans le premier et le second degrés, Ministère de l’Education Nationale

https://eduscol.education.fr/cid53163/les-unites-localisees-pour-l-inclusion-scolaire-ulis.html, consulté le 15/10/2019

[12]:Demander une AVS pour un enfant avec autisme ou autre TED, Danièle Langloys

http://www.autisme-france.fr/offres/file_inline_src/577/577_P_21057_6.pdf, consulté le 15/10/2019

[13]:Gestes professionnels adaptés pour scolariser un élève en situation de handicap, Ministère de l’Education Nationale

https://eduscol.education.fr/cid96837/gestes-professionnels-adaptes-pour-scolariser-un-eleve-en-situation-de-handicap.html, consulté le 15/10/2019

[14]: La méthode TEACCH, autisme.qc.ca

https://www.autisme.qc.ca/tsa/methodes-educatives-interventions/la-methode-teacch.html, consulté le 15/10/2019

[15]: Autisme : zoom sur la méthode Teacch, parents.fr

https://www.parents.fr/bebe/sante/autisme/autisme-zoom-sur-la-methode-teacch-77830, consulté le 15/10/2019

[16]: QU’EST-CE QUE LE PECS®?, PECS-france

https://pecs-france.fr/picture-exchange-communication-system-pecs/, consulté le 15/10/2019

[17]:Mieux connaître le PECS, Enfant-Différent

http://www.enfant-different.org/communiquer-avec-son-enfant/pecs, consulté le 15/10/2019

[18]:PictoTask, une solution pour l’autonomie, PictoTask

https://www.pictotask.com/products/pictotask/pictotask, consulté le 15/10/2019

[19]:Guide d’utilisation de l’application, PictoTask

https://www.pictotask.com/application/files/6315/5145/4137/Guide_dutilisation_de_lapplication.pdf, consulté le 15/10/2019

[20]:Une CAA réussie pour tous, AssistiveWare https://www.assistiveware.com/fr/apprendre-caa, consulté le 15/10/2019

[21]:Des produits intuitifs et centrés sur l’utilisateur, AssistiveWare

https://www.assistiveware.com/fr/produits, consulté le 15/10/2019

[22]:Observatoire des ressources numériques adaptées, INS HEA

http://www.inshea.fr/sites/default/files/fichier-orna/EG_Orna_Communicotool.pdf#overlay-context=fr/users/jramatchandran, consulté le 15/10/2019

[23] https://www.tdahecole.fr/?lang=fr , consulté le 11/11/2019

[24] http://www.douglas.qc.ca/info/trouble-deficit-attention, consulté le 11/11/2019

[25]https://www.cairn.info/les-troubles-de-l-attention-chez-l-enfant–9782100705924-page-7.htm , consulté le 11/11/2019

[26] https://www.larousse.fr/dictionnaires/francais/attention/6247 , consulté le 11/11/2019

[27]https://www.parents.fr/enfant/sante/maladies-rares-chez-l-enfant/trisomie-tout-savoir-sur-cette-maladie-genetique-334144 , consulté le 11/11/2019

[28]https://www.parents.fr/enfant/sante/maladies-rares-chez-l-enfant/trisomie-tout-savoir-sur-cette-maladie-genetique-334144 , consulté le 11/11/2019

[29]https://www.t21.ch/conseils-et-ressources/mythes-et-realites/ , consulté le 11/11/2019

[30]http://www.tsara-autisme.com/, consulté le 11/11/2019

[31] https://watchelp-app.com/, consulté le 11/11/2019

COOCOPARK – Personas

Auteurs : BOUSSARD Tristan, LANTRIN Julien, PREVOST Matthias, RUNACHER Oscar

Pour ce projet nous souhaitons proposer une solution sous la forme d’une application qui indique à l’utilisateur une place de stationnement adaptée à ses critères et le plus proche possible de sa destination.

L’application fournie à l’utilisateur un chemin pour accéder à une place actuellement disponible qui correspond à la taille de son véhicule, à ses critères de prix et à une distance minimale de sa destination. La disponibilité des places est actualisée en temps réel et il est possible de payer sa place depuis l’application ainsi que de la réserver.

Avec ce concept et grâce à nos échanges et notre étude de terrain, nous pouvons écrire trois personas d’utilisateurs de COOCOPARK.

COOCOPARK – Résultats de l’étude terrain.

A l’attention des lecteurs·rices : cet article présentant les résultats de notre étude de terrain, il est amené à être enrichi au fur et à mesure de nos réalisations. Le·a lecteur·rice est donc encouragé·e à consulter cet article régulièrement.

L’étude de terrain nous a permis d’engranger de nombreuses informations des différents acteurs relatifs à notre projets sur leurs besoins, leurs envies ou leurs contraintes. Tous autant qu’ils sont, ils ont été questionnés sur leur cas personnel. Qu’en tirons nous ?

Nous allons présenter ici les résultats suivants les différentes catégories.

Interviews qualitatives auprès d’automobilistes

- Le premier profil de personnes identifié n’utilise pas la voiture personnelle en milieu urbain. Leur vision de l’automobile est assez négative. La perte de temps engendrée par l’utilisation des transports en communs, de la marche ou du vélo est pour eux inexistante ou très faible. Ainsi, par soucis écologique/ financier/quiétude, ils ont choisis une autre solution.

- D’autre personnes au contraire utilisent leur voiture mais pas forcément en milieu urbain. Que ce soit en zone péri-urbaine ou en zone rurale, le stationnement n’est pas forcément un soucis pour eux.

- Finalement, la dernière partie nous a révélé qu’effectivement le problème était récurrent pour certains, que ce soit à Paris ou d’autres métropoles en fin de journée ou même à Brest dans une moindre mesure. Les personnes interrogées trouvent rarement une place dans l’immédiat. Le temps d’attente reste très variable en fonction de la zone mais aussi de l’heure de la journée et des exigences de l’automobiliste. Nous avons pu constater que l’application devra être flexible car chacun a ses propres contraintes et ses propres priorités. En fonction du but du déplacement, la distance stationnement-but acceptable est plus ou moins importante. Certains vont en ville pour faire les magasins ou pour des loisirs. Dans ce cas, l’utilisateur est bien plus flexible que pour un rendez-vous professionnel ou personnel.

Interviews qualitatives auprès de responsables du stationnement

Brest Métropole

Nous sommes entrés en contact avec des entités publiques qui sont acteurs aux sein de leur espace des choix en termes de mobilités. Nous avons pu réaliser un entretien avec Yohann Nédélec, 2ème VP de Brest Métropole chargé des transports, grands projets et de la rade et Ian Le Denemat, chargé de mission au cabinet du maire-président sur les espaces publics et les mobilités.

L’avis reste unanime quant au fait que le nombre de places de stationnement en ville n’augmentera désormais plus. Cependant, l’optimisation de la recherche de place leur semble approprié car en ces temps de transition vers des mobilités propres, il permettra de fluidifier le trafic, diminuer les émissions de CO2, abaisser également les nuisances sonores et les riverains pourront se ré-approprier l’espace urbain. Les élus de l’agglomération brestoise ont fait le constat qu’à certaines heures de nombreux embouteillages dû à la recherche de places se forment en centre ville. Néanmoins, à côté de cela, plusieurs places disponibles existent aux alentours et pourraient être mises en valeurs.

Agence d’urbanisme ADEUPa

Nous avons tenté d’entrer en contact avec l’agence ADEUPa car en tant que spécialistes de l’urbanisme, il nous semblait intéressant d’avoir leur ressenti sur les problématiques de stationnement. Cependant, lors d’un appel téléphonique, il nous a été dit que personne dans l’agence n’était compétent quant à ces questions là. Nous n’avons pas insisté plus que cela car nous avions obtenu un rendez-vous avec Brest Métropole qui sont eux des acteurs sur ces questions.

Brest’Park

Suite à notre entretien à Brest Métropole nous avons obtenu les contacts de la directrice de Brest’Park. Brest’Park étant l’entité qui gère 8 parcs de stationnement et 4000 places payantes sur voirie à Brest.

Nous essayons en ce moment même d’obtenir un rendez-vous avec elle.

WinSumption : Méthodologie de collecte des données

Étude de la limitation des pertes énergétique en résidence : Méthodologie de collecte des données

Cet article présente le déroulement de la recherche sur le terrain et la rencontre avec les parties-prenantes de notre projet. Les verbatims significatifs des entretiens passés et les compte-rendu d’observation seront également présentés.

Article rédigé par : Anass BENFATHALLAH, Jean GUILLAUME, Emile LALO, et Eric TOBITT

Afin de pouvoir mieux identifier les problèmes en résidence étudiante pour pouvoir identifier un besoin et formuler correctement la problématique, nous avons été amené à collecter diverses informations sur le terrain. La collecte de ces informations s’est fait via diverses sources de données :

- Un premier entretien avec MM. Patrice ORUE et Pascal CHARLES, directeur et responsable de la Maison des élèves IMT Atlantique à Brest afin d’obtenir des informations sur les différents problèmes de pertes énergétiques existants dans la résidence. (Voir Annexe 1)

- Un second entretien avec M. Patrice ORUE, directeur de la Maison des élèves IMT Atlantique à Brest, afin d’obtenir des premières réactions sur certaines pistes de solutions, ainsi que nous informer sur les solutions existantes en résidence.

- Un appel téléphonique avec “Bâtiment et techniques”, une entreprise de conseil en efficacité énergétique des bâtiments. Cet appel avait pour but de nous renseigner sur les dispositifs existants dans les nouveaux bâtiments permettant des économies d’énergie et d’évaluer à quel point ces solutions connectées sont utilisées aujourd’hui.

- Un questionnaire envoyé à un panel de résident (notamment de résident de la Maisel de Brest) afin d’être informé sur les habitudes de consommation énergétique des élèves.

De ces différentes sources de données nous avons cherché à identifier plusieurs problèmes et récupérer des réactions sur d’éventuelles solutions. Afin de bien comprendre la réflexion que nous avons eu, une première partie rendra compte des verbatims les plus significatifs que nous avons relevé lors de ces entretiens.

Les verbatims les plus significatifs

Le premier entretien (voir Annexe 1.) avec la Maisel que nous avons eu nous a permis d’identifier plusieurs problèmes de pertes énergétiques existants à la Maisel. Voici les verbatims importants que nous avons relevé.

[Question : Avez-vous relevé des problèmes de sur-consommation à la Maisel ? ]

- “irrespect dans la manière de consommer des étudiants”

- “charges incluses […] implique une consommation sans gêne”

- “ laissent la fenêtre de leur logement ouverte en même temps que le chauffage”

[Question : Avez-vous connaissance de certains problèmes liés à des pertes énergétiques ? ]

- “Il est compliqué pour nous d’estimer les pertes énergétiques”

- “trouver une solution adaptable aux bâtiments de la Maisel déjà construits”

[Question : Quelles solutions avez-vous envisagé pour régler ce problème de pertes énergétiques ? ]

- “Nous avons installé […] un régulateur sur les radiateurs permettant de repérer les chutes de température”

Ce premier entretien nous a permis de comprendre quelles étaient les sources de pertes énergétiques au sein de la Maisel. En effet la consommation non réfléchie des étudiants ainsi que des équipements anciens et non adaptés sont les principaux responsables de la sur-consommation d’énergie. Cet entretien nous a également permis d’identifier un premier besoin dans les résidences étudiantes qui est de pouvoir estimer ces pertes énergétiques afin de mieux contrôler la consommation.

Le second entretien (voir Annexe 2.) est venu en complément du premier. Il nous a permis d’une part, d’identifier les solutions existantes à la Maisel pouvant répondre à notre problématique, et d’autre part d’obtenir une première réaction sur les solutions que l’on pourrait proposer. Voici les verbatims importants que nous avons relevés :

[Question : Seriez-vous intéressé de pouvoir mesurer la consommation énergétique pour chaque chambre ?]

- “les solutions de ce type que nous avons envisagées jusqu’à présent impliqueraient d’énormes travaux et donc d’énormes coûts.”

- “Cette solution permettrait de sensibiliser un peu plus les étudiants”

[Question : Êtes-vous prêt à dépenser plus pour l’écologie ?]

- “en considérant le contexte économique, il est très compliqué d’augmenter le budget”

[Question : Pourquoi les fenêtres restent ouvertes alors que le chauffage est allumé ? ]

- “ la majeure partie des chauffage ne sont pas réglables […] Pour remédier à cela, nous avons prévu d’installer des robinets thermostatiques sur les chauffages permettant le contrôle de la température du logement.”

[Question : Êtes-vous prêt à payer, avec un retour sur investissement à moyen terme, pour une solution innovante de limitation des pertes énergétiques ? ]

- “il pourrait être intéressant d’avoir des propositions de projets innovants au moment des rénovations”

- “un projet d’installation de panneaux solaires sur les bâtiments i12 et i4 a été adopté. Les panneaux solaires ne sont pas rentables et consomment plus que ce qu’ils produisent.”

[Question : Quelle mesures ont été prises par la Maisel pour lutter contre les pertes énergétiques dans les bâtiments ?]

- “projet de calorifugation des tuyaux d’eau chaude pour limiter les pertes d’énergies avec l’extérieur”

- “Un système de relevé des compteurs mensuel permettant un suivi des consommation et d’identifier les anomalies de consommation”

- “Nous avons installé des réducteur de pression “

Ce second entretien nous à permis d’identifier d’autres solutions existantes au sein de la résidence, ainsi que d’évaluer la réaction du directeur de la résidence face aux nouvelles solutions proposées. Les nouveaux problèmes qui ont été remontés lors de cet entretien, nous ont éclairés sur le type de fonctionnalité qu’il était important d’inclure dans notre produit final.

L’entretien téléphonique avec “Bâtiment et Techniques” (Annexe 3) avait pour but d’identifier les types solutions connectées les plus utilisés en pratique pour lutter contre les déperditions énergétiques et la place occupée par ces solutions parmi les conseils donnés par une entreprise spécialisée en efficacité énergétique des bâtiments.

[Question : Quelles solutions existent actuellement pour aider à limiter les pertes énergétiques et en particulier les solutions à partir de capteurs ?]

- RAS

[Question : Oui mais pour contrôler les déperditions ? Si par exemple quelqu’un laisse la fenêtre ouverte, peut-on détecter à l’aide de capteurs qu’il y a de grosses pertes pour ensuite alerter (l’utilisateur par exemple)?]

- “capteurs de température”

- “interagir avec les radiateurs”

- “capteurs qui détectent l’ouverture des fenêtres”

[Question : Cela vous arrive souvent de mettre en place de telles solutions chez vos clients ?]

- “ces solutions existent vraiment”

- “Ce qui importe avant tout c’est de limiter les pertes énergétiques grâce aux choix de construction (type d’énergie utilisée, matériaux, …)”

[Question : Cela arrive-t-il souvent que vos clients viennent vous demander de l’aide pour contrôler leurs pertes énergétiques dans le but de les réduire ?]

- “nos clients […] paient leurs charges en fonction de leur consommation”

- “envisageable pour de l’habitat collectif”

Il en ressort que des capteurs usuels sont les capteurs de température et d’ouverture des fenêtres et que ces solutions connectées ne sont pas dans les conseils privilégiés par cette entreprise, même pour de l’habitat collectif. En effet, les solutions de type ‘une fois pour toutes’ semblent préférées à celles de suivi régulier.

Compte-rendu des données quantitatives récupérées via le questionnaire envoyé

L’idée de ce questionnaire (Voir Annexe 4) était de faciliter la définition du persona “résidant étudiant” en cherchant à quantifier les habitudes des résidents de la Maisel en terme de consommation énergétique. Ce questionnaire nous a permis d’identifier les point importants suivants ;

- Une grande majorité sont sensibles à l’écologie et pensent que des efforts en terme de consommation énergétique sont à faire à la Maisel

- Seulement une minorité des étudiants sont prêt à payer plus pour réduire leur impact environnemental

- Une majorité n’est pas favorable de payer pour ce qu’ils consomment. On peut penser que les résidents non favorables pensent consommer en excès ce qui explique qu’ils préfèrent payer un forfait.

Exploitation des données récupérées

L’ensemble des données récupérées via les différents entretiens et le questionnaire nous ont donné des orientations en ce qui concerne la conception d’un point de vue utilisateur grâce au entretient avec la Maisel, mais également technique grâce à l’entreprise Bâtiment & Technique qui nous a informé des technologies existantes et disponibles à l’installation en terme d’économie d’énergie.

Voici les différentes directions que nous avons décidé d’adopter suite au recueil de ces données :

- Une solution sans coûts excessifs, permettant une réduction de la consommation

- Un système de facturation par logement pourrait permettre une baisse de la consommation

- Une interface utilisateur permettant la sensibilisation à la sur-consommation des résidents

- Une solution utilisant notamment des capteurs de température, d’ouverture, et de lumière

La récupération de ces données s’est également avérée utile pour la rédaction des différents personas (Voir l’article “personas”)

Annexe 1 : Premier entretien avec MM. Patrice ORUE et Pascal CHARLES, Directeur et responsable de la Maison des élèves IMT Atlantique à Brest

Avez-vous relevé des problèmes de sur-consommation à la Maisel ?

Oui nous avons remarqué un problème d’irrespect dans la manière de consommer des résidents. La formule “charge incluse” que nous proposons implique une consommation sans gêne des étudiants. Nous avons aussi remarqué un problème au niveau des départ en vacance, ou il arrive que les élèves laissent la fenêtre de leur logement ouverte en même temps que le chauffage des chambres et des pièces communes continuent de tourner.

Pour certains logements, les radiateurs chauffent en fonction d’une température à atteindre. Il arrive que les étudiants sur-évaluent leur température de confort et entraîne une surchauffe du logement.

Avez-vous connaissance de certains problèmes liés à des pertes énergétiques ?

Il est compliqué pour nous d’estimer les pertes énergétiques par les fenêtres car leurs données se perdent dans la masse et nous ne disposons pas de capteurs individuels pour chaque logement. Ces pertes énergétiques sont un réel problème, et il faudrait trouver une solution adaptable aux bâtiments de la Maisel déjà construits.

Quelles solutions avez-vous envisagé pour régler ce problème de pertes énergétiques ?

Nous disposons d’un système permettant de minimiser l’impact des fenêtres restés ouvertes. Nous avons installé, dans certains logement, un régulateur sur les radiateurs permettant de repérer les chutes de température, et donc d’arrêter de chauffer. Malheureusement ce système n’est pas disponible sur l’ensemble des radiateurs.

Annexe 2 – Le second entretien avec M. Patrice ORUE, Directeur de la Maison des élèves – IMT Atlantique – Brest

Seriez-vous intéressé de pouvoir mesurer la consommation énergétique pour chaque chambre ?

Oui cette solution est très intéressante. Malheureusement, les solutions de ce type que nous avons envisagées jusqu’à présent impliqueraient d’énormes travaux et donc d’énormes coûts. Cette solution permettrait de sensibiliser un peu plus les étudiants à leur consommation. Nous avons constaté plusieurs problèmes tel que les fenêtres ouvertes en même temps que le chauffage est allumé ou les lumières allumées sans personne dans le logement.

Êtes-vous prêt à dépenser plus pour l’écologie ?

Dans le contexte écologique actuel, il est important de faire des efforts à ce niveau là. Cependant, en considérant le contexte économique, il est très compliqué d’augmenter le budget. Uniquement sur le campus de Brest, les charges énergétiques s’élèvent à 78 k€ pour le gaz, 120 k€ pour l’électricité, 57 k€ pour l’eau.

Pourquoi les fenêtres restent ouvertes alors que le chauffage est allumé ?

Il y a plusieurs raisons. D’une part les étudiants sont très peu sensibilisé à leur consommation d’énergie ce qui les entraîne à agir sans se soucier du gâchis d’énergie. D’autre part la majeure partie des chauffages ne sont pas réglables. Il arrive donc que les logements soient surchauffés, et que les étudiants ouvrent donc la fenêtre. Pour remédier à cela, nous avons prévu d’installer des robinets thermostatiques sur les chauffages permettant le contrôle de la température du logement.

Êtes-vous prêt à payer, avec un retour sur investissement à moyen terme, pour une solution innovante de limitation des pertes énergétiques ?

Oui nous sommes ouverts à toutes propositions d’amélioration des logements. Des projets de rénovation sont actuellement en cours pour les bâtiments i1, i2, i3, i5, i6, et i7 et il pourrait être intéressant d’avoir des propositions de projets innovants au moment des rénovations. Cependant des projets ont déjà été soumis et adoptés par la Maisel ces dernière années qui se sont avérés non rentables. Par exemple un projet d’installation de panneaux solaires sur les bâtiments i12 et i4 a été adopté. Les panneaux solaires ne sont pas rentables et consomment plus que ce qu’ils produisent.

Quelle mesures ont été prises par la Maisel pour lutter contre les pertes énergétiques dans les bâtiments ?

Oui plusieurs mesures ont été prises. Nous sommes actuellement en train de mettre en place un projet de calorifugation des tuyaux d’eau chaude pour limiter les pertes d’énergies avec l’extérieur.

La construction du bâtiment i12 datant de 2012 et labellisé Bâtiment Basse Consommation. Il a été construit en bois afin d’être bien isolé, les installations électriques et d’approvisionnement en eau ont été pensées pour être peu consommatrices en énergie.

Un système de relevé des compteurs mensuel permettant un suivi des consommation et d’identifier les anomalies de consommation. Par exemple un bâtiment qui était fermé et sans résident est resté avec un robinet ouvert. Nous avons pu l’identifier à la fin du mois sur le relevé des compteurs.

Nous avons installé des réducteurs de pression sur les robinets ainsi que sur les pommeaux de douche afin de réduire les débits d’eau.

Annexe 3 – Entretien téléphonique en appelant le standard de “Bâtiment et Techniques”, entreprise de conseil en efficacité énergétique de bâtiments

J’ai commencé par leur décrire le contexte qui nous intéresse : Nous cherchons à aider les résidences d’habitat collectif à limiter leurs pertes énergétiques. Nous nous intéressons aux résidences où le chauffage est collectif : les résidents ne paient pas leurs charges directement mais tous paient le même loyer. J’ai même été jusqu’à donner l’exemple des femmes de ménages qui laissent parfois les fenêtres ouvertes dans les espaces communs.

Quelles solutions existent actuellement pour aider à limiter les pertes énergétiques et en particulier les solutions à partir de capteurs ?

Il y a de nombreuses solutions existantes : des capteurs thermiques et solaires en particulier…

Oui mais pour contrôler les déperditions ? Si par exemple quelqu’un laisse la fenêtre ouverte, peut-on détecter à l’aide de capteurs qu’il y a de grosses pertes pour ensuite alerter (l’utilisateur par exemple)?

Oui bien sûr, il y a des capteurs de température qui détectent les chutes de température. De tels capteurs peuvent interagir avec les radiateurs et leur communiquer d’arrêter de chauffer lors d’une chute de température. Il y a aussi des capteurs qui détectent l’ouverture des fenêtres.

Cela vous arrive souvent de mettre en place de telles solutions chez vos clients ?

Parfois; en tous cas, ces solutions existent vraiment. Ce qui importe avant tout c’est de limiter les pertes énergétiques grâce aux choix de construction (type d’énergie utilisée, matériaux, …).

Cela arrive-t-il souvent que vos clients viennent vous demander de l’aide pour contrôler leurs pertes énergétiques dans le but de les réduire ?

Non car nos clients, pour la plupart, paient leurs charges en fonction de leur consommation. Par contre, c’est tout-à-fait envisageable pour de l’habitat collectif.

Annexe 4 – Questionnaire étudiant

Le questionnaire était composé de 5 questions permettant d’évaluer le point de vue des résidents vis-à-vis de la consommation d’énergie. Nous avons obtenu 32 réponses. Les résultats sont présentés sous forme de diagramme circulaire.

Aide à l’apprentissage des enfants atteints de TDA : méthodologie

Méthodologie, administration et analyse des données

PRÉPARATION DE L’ÉTUDE TERRAIN

Afin de favoriser l’apprentissage des enfants atteints de troubles de l’attention, nous avons décidé de concevoir un objet communicant. Cependant, nous devions traiter un sujet qui nous était totalement inconnu. En effet, non seulement nous avions rencontré très peu de personnes atteintes de ces troubles, mais nous ne savions pas non plus quel était leur quotidien, leurs problèmes liés à l’apprentissage, et les solutions que leur entourage avait mis en place pour les aider.

Dans un souci de comprendre au mieux les problématiques de ces enfants lors de leur apprentissage, nous avons donc décidé de contacter des personnes chargées de l’éducation de tels enfants (parents, famille, associations…), qui rencontrent quotidiennement ces problèmes. En effet, le bénéficiaire de notre objet connecté est assez compliqué à définir. Même si cet objet bénéficiera aux enfants ayant des problèmes concernant l’apprentissage (en particulier les enfants trisomiques et autistes), cet objet sera utilisé, programmé et à destination de leurs éducateurs. Dans le cas d’une famille, l’enfant sera le bénéficiaire mais ses parents ses utilisateurs. Il y a donc une double approche à considérer dans la définition du besoin : les besoins de l’enfant (le bénéficiaire), et les besoins de ses éducateurs.

ORGANISATION

Nous sommes un groupe de 3 personnes pour ce projet, et il nous a semblé important de s’organiser pour la partie collecte de données.

En effet, travailler séparément nous permettait de travailler plus efficacement et plus rapidement que de travailler en groupe, tous sur la même chose, et nous permettait aussi d’avoir 3 points de vue différents sur le sujet, chacun forgé par des recherches personnelles. La confrontation de ces points de vue et le rassemblement des résultats des recherches ont permis un approfondissement du sujet, plus détaillé, avec des ajouts que chacun apportait aux autres de part ses recherches personnelles. Cependant, il ne fallait pas chercher la même chose, car nous aurions pu faire le même travail, les mêmes recherches…

Ainsi, un membre du groupe a étudié de façon scientifique les troubles de l’attention (définition, caractérisation, apparition, conséquences…), un autre membre les problèmes que ces troubles entraînent, et le dernier membre du groupe a étudié les solutions.

Ainsi, lors des séances de travail commun, chaque membre a pu présenter les résultats de ses recherches, qui sont alors entrés en résonance avec ceux des autres, les complétant.

Une autre part de la recherche d’informations doit aussi être faite grâce à une étude de terrain (interviews, observations…) et cette partie est extrêmement importante pour notre sujet, car il met en jeu des problématiques relationnelles, qui peuvent difficilement être comprises sans contact avec les personnes concernées. Chaque membre du groupe a alors regardé dans son entourage puis sur Internet, afin de trouver des personnes pouvant nous aider. Un membre du groupe recherchait des contacts auprès des institutions Étatiques (Education National, école primaire…), et les deux autres membres auprès d’associations et d’institutions.

PARTIES PRENANTES ET MÉTHODOLOGIE

Nous avons trouvé plusieurs association susceptibles de nous aider :

La fondation Jérôme Lejeune, qui a différents objectifs :

- La recherche médicale sur les maladies de l’intelligence d’origine génétique

- L’accueil et le soin des personnes, notamment celles atteintes de trisomie 21 ou d’autres anomalies génétiques, et qui s’occupe donc quotidiennement d’enfants trisomiques

- La défense de la vie et de la dignité de ces personnes, qui doivent être respectées de la conception à la mort naturelle

L’association A Bras Ouverts, une association reconnue de bienfaisance qui rassemble, le temps de week-ends ou de courts séjours, des accompagnateurs de 18 à 35 ans et des jeunes porteurs de handicap.

Les “Cafés Joyeux”, une famille de Coffee-Shops qui emploie et forme des personnes en situation de handicap mental et cognitif, et en particulier des personnes atteintes de la trisomie 21.

Nous souhaitions donc contacter ces personnes et ces associations, et à l’aide de questions dans un premier temps assez larges, connaître leur quotidien, les problèmes d’apprentissage des enfants et les solutions mises en places. Par exemple, la fondation Jérôme Lejeune accompagne au quotidien de nombreux enfants trisomiques, et leur poser des questions sur les points communs et les différences de chaque enfant, afin de savoir si notre objet et les fonctionnalités pourraient être adaptés pour tous les enfants était une des raisons principales de notre volonté d’entrer en contact avec eux. Ces associations étant à Paris, un Skype ou un appel audio étaient les solutions les plus envisageable. Cependant, les deux dernières associations ne se sentaient pas capables de nous donner des informations pertinentes pour notre projet, et la fondation Jérôme Lejeune était trop débordé pour nous accorder du temps.

Ainsi, la recherche d’associations susceptibles de nous aider n’a pour l’instant pas débouché sur des entretiens, mais les recherches continuent.

Concernant les institutions Étatiques, nous avons réussi à obtenir le contact d’une personne à la mairie de Brest, chargée des enfants trisomiques et autistes en école primaire. A cause des vacances scolaires, nous n’avons pas pu entrer directement en contact avec cette personne. Nous envisageons de lui demander la permission d’aller observer la matinée d’un enfant autiste ou trisomique en classe, afin de comprendre les problèmes, son comportement, et les solutions mises en place par les parents et les professeurs. Une discussion avec ces derniers serait aussi très intéressante, et nous permettra de connaître et d’observer la réalité du terrain.

Enfin, nous avons eu de nombreux contacts de particuliers, via nos connaissances. Un membre du groupe avait un collègue dont la petite fille était autiste, un autre avait un ami dont la petite soeur était trisomique, et nous avons eu le contact d’une maman psychomotricienne, qui a une enfant autiste

Pour le premier contact, nous avons réussi à rapidement avoir un entretien vocal avec lui (voir résumé ci-joint), qui nous a permi de très vite comprendre la réalité du terrain. Le deuxième contact s’est proposé de nous rédiger un texte en réaction au résumé de l’interview, et d’un récapitulatif de notre travail et de notre solution. Enfin, le troisième contact a proposé un entretien, mais a précisé aussi qu’elle était disposé à faire passer un questionnaire à des adultes autistes et à des parents qui ont un enfant autiste, afin que nous puissions avoir un grand nombre de réponses.

INTERVIEWS ET OBSERVATIONS

Nous avons eu la possibilité d’avoir un entretien audio avec le collègue d’une membre du groupe, qui a un fils autiste. Son fils est atteint d’autisme de haut niveau, dont le principal problème est l’incapacité d’interactions sociales, ce qui est très problématique, notamment à l’école, dans la construction de l’enfant. En effet, alors que leur fils a d’abord suivi l’école classique, ce dernier a fait plusieurs crises de panique, et était renfermé sur lui, ce qui a poussé ses parents à lui faire cours à la maison.

Que cela soit à l’école ou à la maison, les parents ont distingué deux problèmes distincts, mais étroitement liés, concernant les capacités d’apprentissage de l’enfant. Premièrement, leur enfant, et les enfants autistes et trisomiques en général, ont besoin de se sentir protégé, en sécurité. Autrement, ils paniquent, et cela entraîne souvent le second problème : le manque d’attention. Ce dernier peut apparaître suite à une crise de panique, ou quotidiennement, si l’enfant n’est pas assez stimulé.

Ainsi, il faut à la fois faire en sorte que l’enfant se sente en sécurité, et le stimuler pour ramener son attention au cours, sans pour autant trop le distraire. Il s’agit là d’un équilibre compliqué à trouver, qu’il est difficile d’imposer à tous les enfants autistes et trisomiques. L’idée d’un objet connecté programmable par les parents est alors apparu. C’est aux parents qu’il incombe de trouver cet équilibre, et de personnaliser l’objet au plus près des besoins de leur enfant.

De plus, concernant les fonctionnalités de cet objet, l’expérience de ce père de famille nous a été très utile. En effet, il nous a indiqué les moyens testés qui avaient été utiles pour lui, comme des photos de la famille ou du chien dans la trousse ou sur un gadget numérique, une écharpe de la mère de l’enfant imprégné de son odeur, des lumières douces et apaisantes, des objets doux au toucher…

Grâce aux recherches Internet effectuées, nous avions déjà pu identifier les problèmes des enfants autistes et trisomiques concernant l’apprentissage : le sentiment d’insécurité, et les problèmes d’attention. Et très naturellement, nous avions pensé à un objet utilisant la lumière pour ramener son attention, et l’odeur et le toucher pour le rassurer. Cet entretien est donc venu confirmer et compléter nos suppositions.

Finalement, selon le père de cet enfant autiste, le produit idéal serait un objet connecté qui pourrait afficher des couleurs douces pour rassurer, un flash rouge pour ramener l’attention, et permettre la visualisation de photos (entre 5 et 10). De plus, cet objet devrait pouvoir être programmable par les parents, avec un timer (couleurs douces toutes les 5 minutes) ou alors des horaires fixes (flash rouge tous les jours à 11h), et personnalisable au niveau des photos et des couleurs.

EVOLUTION DE NOTRE POINT DE VUE

Ces recherches, cette interview et les discussions que nous avons eu avec ces personnes nous ont permis de faire évoluer notre point de vue sur le sujet et sur les problèmes.

Comme dit ci-dessus, nous avions eu l’intuition, qui a été confirmée par la suite, qu’un objet utilisant des couleurs douces et des musiques pourraient calmer l’enfant. Cependant, l’interview nous a permis de bien comprendre la relation de cause à effet entre le sentiment d’insécurité de l’enfant, et ses problèmes d’attention, et nous a été utile pour répondre à deux questions, qui étaient importantes.

La première question était de savoir quand déclencher les lumières ou l’apparition des photos sur l’objet. Nous avions pensé à un capteur qui, collé sur la peau de l’enfant, permettait de prendre sa tension, son pouls, et de réagir en cas de hausse ou de baisse importante. Cependant, cela était logistiquement compliqué à mettre en place (comment fixer les seuils?), et peu précis. Ainsi, l’idée d’un objet programmable par les parents s’est présenté comme la meilleure solution, la plus simple et la plus adaptée, car cela permettait aussi (comme dis plus haut) de laisser la possibilité aux parents de personnaliser l’objet.